Здравия! Объясните пожалуйста физику процесса:

почему у некоторых SSD при заполнении катастрофически падает скорость РАНДОМНОГО ЧТЕНИЯ? Последовательное чтение блоками по 1 Магебайту тоже падает, но это интереса не представляет.

Про запись понятно, но причем чтение? Есть ли свзять с памятью TLC или QLC?

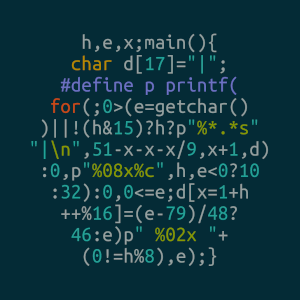

Пример: новый диск (dd zero) выдает 3200 МБ/c (800k IOPS), после заполнения (dd urandom) на 100% выдает 520МБ/c (130k IOPS). Контроллер Maxio MAP1602, память YMTC TLC.

Особо интересует чтение рандомных блоков от 4K до 16K и работа на PCIe 3.0. Файловой системы нет, диск заполнен рандомом на весь объём.

Спасибо!