Имеется:

- Дисковая полка Supermicro CSE-826BE1C-R741JBOD с подключенными в неё 4 дисками

- серверА и серверБ подключенные к полке

- Логически диски организованы как Raid6 и lvm поверх него

- Оба сервера видят диски полки. И оба сервера на своей стороне собирают RAID и LVM

- Пользуется внутренностями данных на данный момент только серверА (куча VM, логические диски которых на полке), он же периодически делает бэкапы используя LVM SNAP

- серверБ на данный момент «просто подключен» к полке и логические lvm тома дисков полки «не трогает»

Надо:

- подключить ещё один серверВ к полке

- все сервера начнут активно использовать lvm тома от дисков на полке

Собственно, я уже примерно догадываюсь, что в том что сейчас есть нет ничего «кластерного» и то, что 2 сервера имеют параллельный доступ к дискам не есть хорошо. Но понимания как это объяснить кроме «возможных» проблем нет.

Вопрос: а как бы это всё разрулить чтобы оно физически осталось примерно также реализовано, но логически быть уверенным в консистентности данных?

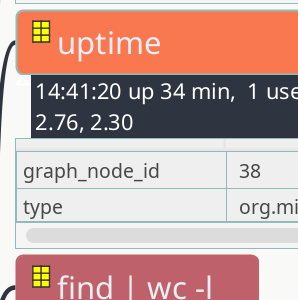

Пример проблемы: Я создаю lvm том на серверА и серверБ его видит(lvs), но если создать lvm том на серверБ, то серверА его не видит