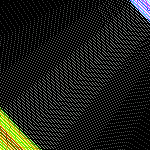

Тут, наверное, пару недель назад кто-то сказал, что было бы интересно взглянуть на карту русской википедии по ссылкам внутри статей. Заюзав все свои 4 гб оперативы и сутки времени, я закодил и сгенерил таковую карту (в качестве helloworld, просто хотел освоить python).

Характеристики:

1 пиксель может содержать от 1 до 4 статей. Чем больше статей в пикселе, тем он светлее. Пиксели без статей чёрные.

Оттенок пикселя определяется средним количеством исходящих и входящих ссылок данной статьи таким образом:

1-33: голубой

34-66: зелёный

67-99: жёлтый

99: красный

Очевидно, красные пиксели — классификаторы разного рода: по датам, по направлениям и т.п, а голубые и зелёные — обыкновенные статьи среднего размера.

На карте видно:

- Ядро энциклопедии, статья «Россия», а также статьи о других странах (маленький красный кружок в центре)

- 9 сравнительно независимых участков энциклопедии

- сотни статей, не связанных с остальными (плавают вокруг основной области связности)

- 8 основных веток классификаторов, простирающихся от ядра

Следует отметить, что мне чуть-чуть не хватило RAM, чтобы распарсить всю русскую википедию, так что карта построена по половине ссылок (порядка 600 000) и половине связей (около 16 млн). На днях собираюсь докупить рамы и сгенерировать полную карту, включая попиксельную расшифровку, чтобы добавить интерактивности.