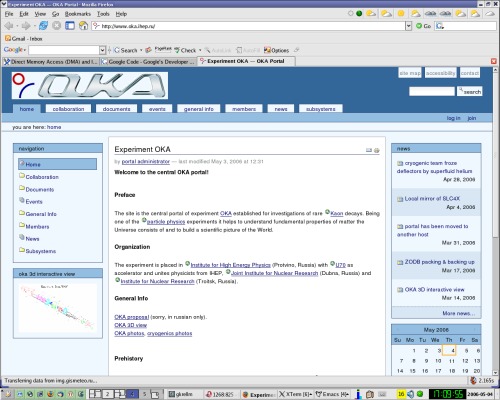

В феврале рассматривал несколько CMS и остановился на Plone. Достаточно удобная и гибкая CMS для неискушённого пользователя ресурса (спасибо разработчикам - почти всё сделано через интуитивно-понятный ГУЙ). Посетители тоже не оставлены разработчиками Plone в обиде, куча "фенечек" вроде live search и календаря идёт штатно с этой CMS. Среди нескольких сотен add-ons попадаются весьма полезные (как например PloneArticle), но напильником работать всё равно приходится, а благодаря питону делается это на раз-два-три, больше времени уходит на чтение доков по Plone. Пока не настроил extern storage, не получилось с наскока, в результате всё содержимое хранится в ZODB, что нехорошо. Содержимого пока немного - сам физ-эксперимент только строится.

>>> Просмотр (1280x1024, 318 Kb)