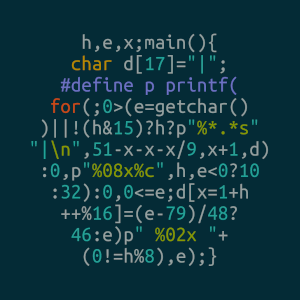

Здесь написано следующее:

All writes in other threads that release the same atomic variable are visible in the current thread

All writes in the current thread are visible in other threads that acquire the same atomic variable

Это про acquire и release. Это обобщённая модель или существует/существовало железо, где действительно можно было не увидеть изменения из другого потока? Если да, то с какой целью такое поведение у железа было сделано?