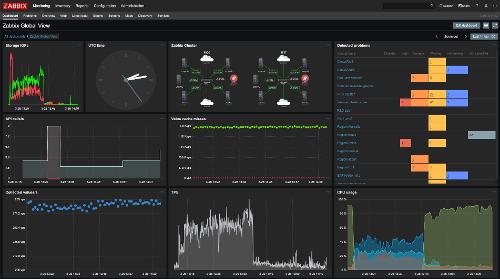

Состоялся релиз свободной системы мониторинга с открытым исходным кодом Zabbix 4.2. Zabbix – универсальная система для мониторинга производительности и доступности серверов, инженерного и сетевого оборудования, приложений, баз данных, систем виртуализации, контейнеров, ИТ-сервисов, веб-сервисов.

Система реализует полный цикл от сбора данных, их обработки и преобразования, анализа получаемых данных, и заканчивая хранением этих данных, визуализацией и рассылкой оповещений с использованием правил эскалаций. Также система предоставляет гибкие возможности расширения методов сбора данных и оповещений, а также возможности автоматизации через API. Единый веб-интерфейс реализует централизованное управление конфигурациями мониторинга и распределением прав доступа различным группам пользователей. Код проекта распространяется под лицензией GPLv2.

Zabbix 4.2 - это новая не LTS-версия с коротким сроком официальной поддержки. Для пользователей, которые ориентируются на длинный цикл эксплуатации программных продуктов, рекомендуем использовать LTS версии продукта, такие как 3.0 и 4.0.

Основные улучшения версии 4.2:

- Доступность официальных пакетов для следующих платформ:

- RaspberryPi, SUSE Enterprise Linux Server 12

- MacOS агент

- MSI сборка Windows agenta

- Docker образы

- Мониторинг приложений с помощью высокоэффективного сбора данных из экспортеров Prometheus и встроенной поддержкой PromQL, также поддерживается и низкоуровневое обнаружение

- Высокочастотный мониторинг для сверхбыстрого обнаружения проблем с помощью тротлинга (throttling). Тротлинг позволяет осуществлять проверки со сверхбольшой частотой, не обрабатывая и не храня при этом огромные объёмы данных

- Валидация входных данных в предварительной обработке по регулярным выражениям, интервалу значений, JSONPath и XMLPath

- Управление поведением Zabbix при ошибках в шагах предварительной обработки, появилась возможность игнорирования нового значения, возможность установить значение по умолчанию или задать произвольное сообщение об ошибке

- Поддержка произвольных алгоритмов для предварительной обработки с использованием языка JavaScript

- Более простое низкоуровневое обнаружение (LLD) с поддержкой произвольно оформленных данных в формате JSON

- Экспериментальная поддержка высокоэффективного хранилища TimescaleDB с автоматическим партицированием

- Простое управление тегами на уровне шаблонов и хостов

- Эффективное масштабирование нагрузки за счёт поддержки предварительной обработки данных на стороне прокси. В комбинации с тротлингом такой подход позволяет выполнять и обрабатывать миллионы проверок в секунду, не нагружая при этом центральный Zabbix сервер

- Гибкая авторегистрация устройств с фильтрацией имён устройств по регулярному выражению

- Возможность управления именами устройств при сетевом обнаружении (network discovery) и получения имени устройства из значения метрики

- Удобная проверка правильности работы препроцессинга прямо из интерфейса

- Проверка работоспособности способов оповещения прямо из Веб-интерфейса

- Удалённых мониторинг внутренних метрик Zabbix сервера и прокси (метрик производительности и работоспособности компонентов Zabbix)

- Красивые e-mail сообщения, благодаря наличию поддержки формата HTML

- Поддержка новых макросов в пользовательских URL для лучшей интеграции карт с внешними системами

- Поддержка анимированных GIF изображений на картах для более заметной визуализации проблем

- Показываем точное время при наведении мышкой на график

- Удобный новый фильтр в конфигурации триггеров

- Возможность массового изменения параметров прототипов метрик

- Возможность извлечения данных, в том числе токенов авторизации, из заголовков HTTP в веб-мониторинге

- Zabbix Sender теперь отправляет данные по всем IP адресам из конфигурационного файла агента

- Правило обнаружения может быть зависимой метрикой

- Реализован более предсказуемый алгоритм для изменения порядка расположения виджетов в dashboard (панели)

Для перехода с более ранних версий необходима лишь установка новых бинарных файлов (сервера и прокси) и нового интерфейса. Zabbix автоматически проведёт процедуру обновления базы данных. Установка новых агентов не потребуется.

С полным списком всех изменений вы можете ознакомиться в документации.

Статья на Хабре предлагает более подробное описание функциональности.

>>> Подробности